新站若不进行搜索引擎优化,就仿佛在熙熙攘攘的人群里穿着不显眼的衣服,即便内容质量上乘,也难以让潜在客户注意到。虽然免费流量获取的绝佳时机尚未结束,但所采用的方式一定要精准且高效。

确定核心关键词

选关键词不能随意。要借助5118或Google Keyword Planner这类专业工具,考察搜索热度、竞争状况以及商业倾向。比如,本地家政网站,不能只关注“家政”,得具体到“上海浦东新区专业家政服务”,这种更细致的词组,效果会更好。

选定目标后,要有序地把关键词安排在标题、描述、文章开头和图片的替代文本里。一定要注意不要胡乱堆放,必须让它们自然地结合在一起。中心词要像一条主线,把整个站点的信息串联起来,帮助搜索引擎和访问者明白你的主要业务是什么。

持续产出优质内容

内容是招徕搜索引擎收录和让人愿意停留的关键,品质好不仅在于文章是第一次写,更在于它能否提供切实有用的信息。比如,一篇谈“怎样挑选净水设备”的文章,需要包含品牌间的分析,技术指标的解释,以及当地安装公司的评价。

除了文字表述,也要多运用图像和影像资料。2023年的统计表明,带有视频内容的网页,访客平均停留时间增加了百分之七十。要经常更新内容号外资源网,比如每七天发布两篇有深度的文章,这样能够帮助网络爬虫养成定期访问的规律,并且可以逐步增强网站的排名情况。

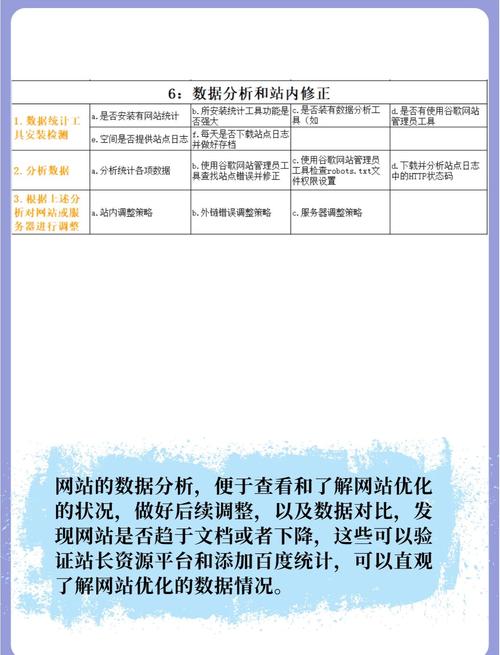

正确配置Robots文件

网站会通过一个特定文件给搜索引擎的爬虫下达第一条指令,这个文件叫做robots.txt。如果设置不当,可能会把一些关键的页面给屏蔽掉,让之前的优化努力全部白费。很多初学者会犯一个错误,就是用“Disallow: /”这样一条指令完全禁止爬虫访问,所以一定要认真检查这个文件里的内容。

规范操作是,只有当存在特殊目录(比如后台管理)必须保密时,才应该阻止爬虫获取大部分信息。你可以借助Google Search Console里的“ robots.txt 测试功能”做模拟检查,保证重要页面例如商品信息页、文章详情页都没有被错误地屏蔽。

完善站内SEO基础设置

网站内部配置是优化搜索引擎的关键基础。首先,要保证网站的技术状态良好,比如,要设计出能让用户顺利返回的404错误提示页面,用301跳转解决网址过期的状况,还要准备XML形式的网站地图,并提交给搜索引擎的爬虫,这样它们就能完整地检索网站内容。

此外,必须关注细节改进:给网站加入组织化信息标注,比如标识图形和公司称号,让搜索平台能更好地认识信息;采用安全通信协议,增强安全水平;保证网页在手机等移动设备上运行流畅且界面适配,这些方面都关乎搜索结果的靠前程度。

定期排查与处理死链

失效的网页地址,也就是用户访问时显示的404错误页面,会降低用户的满意度,同时也会消耗搜索引擎用于爬取网页的资源。新建立的网站,由于内容的更新或者程序上出现的问题,很容易形成失效的链接。建议每个月都借助类似Xenu's Link Sleuth这样的软件,对整个网站进行全面的检查。

找到失效链接后,有两种应对方法,一种是,如果页面已经没有了,需要在服务器上设置永久跳转,指向那个新的相关页面,另一种是,如果页面内容很特别,只是暂时不能用了,就应该把那些坏链接的清单交给谷歌搜索平台,这样能防止它们影响整个网站的排名。

保持耐心并关注用户体验

搜索引擎优化是一项持久战,不是短跑竞赛。新网站一般要花一个到三个月的时间,才能开始显现一些成效。这段时间里,千万不要为了急于获得收录,就使用复制内容或者大量发送外部链接这类不正当的方法,这样非常容易让网站受到处罚。

要想获得持续的搜索位置,用户感受是关键因素。要留意网页打开快慢,最好三秒内完成,内容要方便阅读,多分段落,加上小标题,还要深入地解答问题。搜索引擎最想要做的是,把最能满足用户要找的东西展示给他们看。

调整网站时,最大的困难是确定核心词还是构思文章?大家在评论里谈谈自己的看法,要是觉得这篇文章有用,也请点个赞鼓励一下!